Een werkend AI-model is gebaseerd op solide, betrouwbare en dynamische datasets. Zonder rijk en gedetailleerd AI-trainingsgegevens bij de hand is het zeker niet mogelijk om een waardevolle en succesvolle AI-oplossing te bouwen. We weten dat de complexiteit van het project de vereiste kwaliteit van gegevens dicteert en bepaalt. Maar we weten niet precies hoeveel trainingsgegevens we nodig hebben om het aangepaste model te bouwen.

Er is geen eenduidig antwoord op wat de juiste hoeveelheid is trainingsgegevens voor machine learning is nodig. In plaats van met een margefiguur te werken, geloven we dat een hele reeks methoden u een nauwkeurig idee kunnen geven van de gegevensgrootte die u mogelijk nodig heeft. Maar laten we eerst eens begrijpen waarom trainingsgegevens cruciaal zijn voor het succes van uw AI-project.

Het belang van trainingsgegevens

Arvind Krishna, CEO IBM, zei tijdens het Future of Everything-festival van The Wall Street Journal dat bijna... 80% van het werk in een AI-project gaat over het verzamelen, opschonen en voorbereiden van data.' En hij was ook van mening dat bedrijven hun AI-ondernemingen opgeven omdat ze de kosten, het werk en de tijd die nodig zijn om waardevolle trainingsgegevens te verzamelen niet kunnen bijhouden.

Bepalen van de gegevens steekproefomvang helpt bij het ontwerpen van de oplossing. Het helpt ook om de kosten, tijd en vaardigheden die nodig zijn voor het project nauwkeurig in te schatten.

Als onnauwkeurige of onbetrouwbare datasets worden gebruikt om ML-modellen te trainen, zal de resulterende toepassing geen goede voorspellingen geven.

Hoeveel gegevens zijn genoeg?

Het hangt er van af.

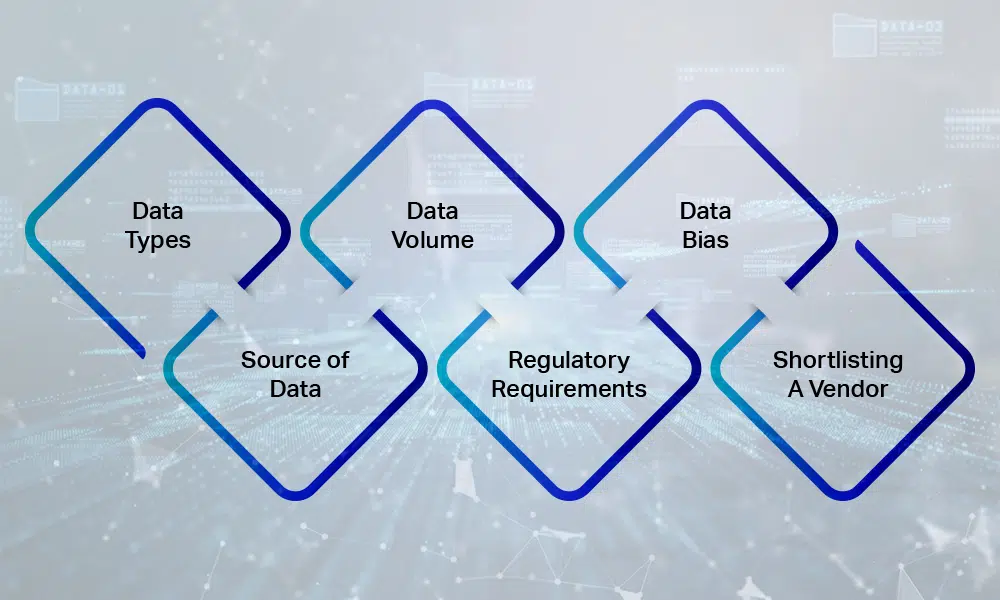

De hoeveelheid gegevens die nodig is, is afhankelijk van verschillende factoren, waaronder:

- De complexiteit van de Machine learning-project je onderneemt

- De complexiteit van het project en begroting bepaal ook de trainingsmethode die u toepast.

- De etiketterings- en annotatiebehoeften van het specifieke project.

- Dynamiek en diversiteit aan datasets die nodig zijn om een op AI gebaseerd project nauwkeurig te trainen.

- De gegevenskwaliteitsbehoeften van het project.

Opgeleide gissingen maken

Er is geen magisch getal met betrekking tot de minimaal benodigde hoeveelheid gegevens, maar er zijn een paar vuistregels die u kunt gebruiken om tot een rationaal getal te komen.

De regel van 10

Als vuistregel, om een efficiënt AI-model te ontwikkelen, moet het aantal benodigde trainingsdatasets tien keer meer zijn dan elke modelparameter, ook wel vrijheidsgraden genoemd. De '10' keer regels hebben tot doel de variabiliteit te beperken en de diversiteit aan gegevens te vergroten. Als zodanig kan deze vuistregel u helpen uw project op gang te brengen door u een basisidee te geven over de vereiste hoeveelheid datasets.

Diepe leren

Deep learning-methoden helpen bij het ontwikkelen van hoogwaardige modellen als er meer gegevens aan het systeem worden verstrekt. Het is algemeen aanvaard dat het hebben van 5000 gelabelde afbeeldingen per categorie voldoende zou moeten zijn voor het creëren van een deep learning-algoritme dat vergelijkbaar is met dat van mensen. Om uitzonderlijk complexe modellen te ontwikkelen, zijn minimaal 10 miljoen gelabelde items nodig.

Computer visie

Als je deep learning gebruikt voor het classificeren van afbeeldingen, is er een consensus dat een dataset van 1000 gelabelde afbeeldingen voor elke klasse een redelijk aantal is.

Leercurven

Leercurves worden gebruikt om de prestaties van het machine learning-algoritme te demonstreren tegen de hoeveelheid gegevens. Door de modelvaardigheid op de Y-as en de trainingsdataset op de X-as te hebben, is het mogelijk om te begrijpen hoe de grootte van de gegevens de uitkomst van het project beïnvloedt.

De nadelen van te weinig gegevens

Je zou denken dat het nogal voor de hand liggend is dat een project grote hoeveelheden data nodig heeft, maar soms slagen zelfs grote bedrijven met toegang tot gestructureerde data er niet in om deze aan te schaffen. Training op beperkte of smalle datahoeveelheden kan de machine learning-modellen van het bereiken van hun volledige potentieel en verhogen het risico op het verstrekken van verkeerde voorspellingen.

Hoewel er geen gouden regel is en er meestal grove generalisaties worden gemaakt om te voorzien in de behoefte aan trainingsgegevens, is het altijd beter om grote datasets te hebben dan te lijden onder beperkingen. De gegevensbeperking waar uw model last van heeft, zijn de beperkingen van uw project.

Wat te doen als u meer datasets nodig heeft

Hoewel iedereen toegang wil hebben tot grote datasets, is dat makkelijker gezegd dan gedaan. Het verkrijgen van toegang tot grote hoeveelheden datasets van kwaliteit en diversiteit is essentieel voor het succes van het project. Hier bieden we u strategische stappen om het verzamelen van gegevens veel gemakkelijker te maken.

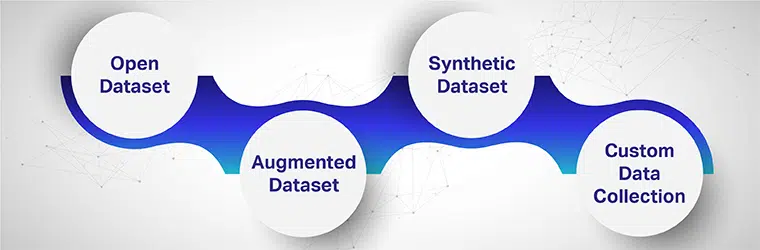

Gegevensset openen

Open datasets worden doorgaans beschouwd als een 'goede bron' van gratis data. Hoewel dit waar kan zijn, zijn open datasets in de meeste gevallen niet wat het project nodig heeft. Er zijn veel plaatsen waar gegevens kunnen worden verkregen, zoals overheidsbronnen, EU Open-dataportals, Google Public-gegevensverkenners en meer. Er zijn echter veel nadelen aan het gebruik van open datasets voor complexe projecten.

Wanneer u dergelijke datasets gebruikt, loopt u het risico trainen en testen uw model op onjuiste of ontbrekende gegevens. De methoden voor het verzamelen van gegevens zijn over het algemeen niet bekend, wat de uitkomst van het project kan beïnvloeden. Privacy, toestemming en identiteitsdiefstal zijn belangrijke nadelen van het gebruik van open databronnen.

Uitgebreide dataset

Als je wat hebt hoeveelheid trainingsgegevens maar niet genoeg om aan al uw projectvereisten te voldoen, moet u technieken voor gegevensvergroting toepassen. De beschikbare dataset wordt hergebruikt om aan de behoeften van het model te voldoen.

De datasamples ondergaan verschillende transformaties die de dataset rijk, gevarieerd en dynamisch maken. Een eenvoudig voorbeeld van gegevensvergroting is te zien bij het omgaan met afbeeldingen. Een afbeelding kan op vele manieren worden vergroot: het kan worden gesneden, vergroot of verkleind, gespiegeld, in verschillende hoeken worden veranderd en kleurinstellingen kunnen worden gewijzigd.

Synthetische gegevens

Wanneer er onvoldoende gegevens zijn, kunnen we ons wenden tot synthetische datageneratoren. Synthetische data is handig in termen van transfer learning, omdat het model eerst kan worden getraind op synthetische data en later op de real-world dataset. Een op AI gebaseerd zelfrijdend voertuig kan bijvoorbeeld eerst worden getraind om objecten te herkennen en te analyseren in computer visie videogames.

Synthetische gegevens zijn nuttig als er een gebrek is aan real-life gegevens om te trainen en test je getrainde modellen. Bovendien wordt het ook gebruikt bij het omgaan met privacy en gegevensgevoeligheid.

Aangepaste gegevensverzameling

Aangepaste gegevensverzameling is misschien ideaal voor het genereren van datasets wanneer andere vormen niet de vereiste resultaten opleveren. Gegevenssets van hoge kwaliteit kunnen worden gegenereerd met behulp van webscraping-tools, sensoren, camera's en andere tools. Wanneer u op maat gemaakte datasets nodig heeft die de prestaties van uw modellen verbeteren, kan het aanschaffen van aangepaste datasets de juiste zet zijn. Verschillende externe dienstverleners bieden hun expertise aan.

Om hoogwaardige AI-oplossingen te ontwikkelen, moeten de modellen worden getraind op betrouwbare datasets van goede kwaliteit. Het is echter niet eenvoudig om rijke en gedetailleerde datasets te bemachtigen die de resultaten positief beïnvloeden. Maar wanneer u samenwerkt met betrouwbare dataproviders, kunt u een krachtig AI-model bouwen met een sterke databasis.

Heeft u een geweldig project in gedachten, maar wacht u op op maat gemaakte datasets om uw modellen te trainen of worstelt u om het juiste resultaat uit uw project te halen? We bieden uitgebreide trainingsdatasets voor verschillende projectbehoeften. Benut het potentieel van Shaip door te praten met een van onze data wetenschappers en begrijpen hoe we in het verleden hoogwaardige datasets van hoge kwaliteit voor klanten hebben geleverd.