Als u een AI-oplossing ontwikkelt, is de time-to-market van uw product sterk afhankelijk van de tijdige beschikbaarheid van hoogwaardige datasets voor trainingsdoeleinden. Pas als u de benodigde datasets bij de hand heeft, start u de trainingsprocessen van uw modellen, optimaliseert u de resultaten en maakt u uw oplossing klaar voor lancering.

En weet je, het op tijd ophalen van hoogwaardige datasets is een enorme uitdaging voor bedrijven van elke omvang en schaal. Voor niet-ingewijden, dichtbij 19% van de bedrijven onthullen dat het het gebrek aan beschikbaarheid van gegevens is dat hen ervan weerhoudt om AI-oplossingen te gebruiken.

We moeten ook begrijpen dat zelfs als u erin slaagt om relevante en contextuele gegevens te genereren, gegevens annotatie is een uitdaging op zich. Het is tijdrovend en vereist een uitstekende beheersing en aandacht voor detail. Ongeveer 80% van de ontwikkeltijd van een AI gaat op aan het annoteren van datasets.

Nu kunnen we gegevensannotatieprocessen niet zomaar volledig uit onze systemen verwijderen, omdat ze het steunpunt vormen van AI-training. Uw modellen zouden geen resultaten opleveren (laat staan kwaliteitsresultaten) als er geen geannoteerde gegevens voorhanden zijn. Tot nu toe hebben we talloze onderwerpen besproken over op gegevens gebaseerde uitdagingen, annotatietechnieken en meer. Vandaag bespreken we een ander cruciaal aspect dat draait om het labelen van gegevens zelf.

In dit bericht zullen we de twee soorten annotatiemethoden onderzoeken die in het hele spectrum worden gebruikt, namelijk:

- Handmatige gegevenslabeling

- En automatische gegevenslabeling

We zullen licht werpen op de verschillen tussen de twee, waarom handmatige interventie essentieel is en wat de risico's zijn die gepaard gaan met automatisch? data-etikettering.

Handmatige gegevenslabeling

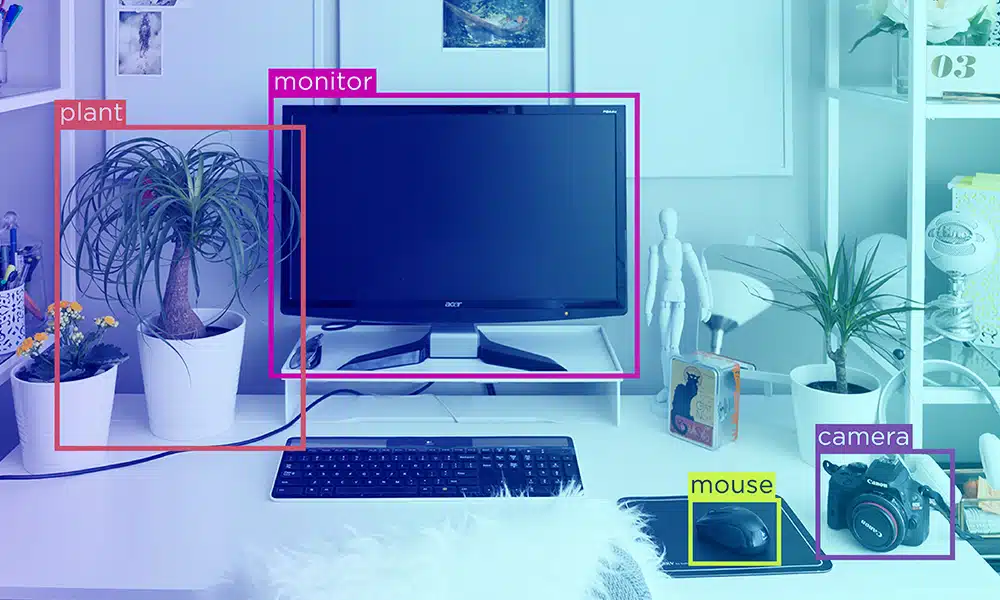

Zoals de naam al doet vermoeden, zijn bij handmatige gegevensetikettering mensen betrokken. Experts op het gebied van gegevensannotatie nemen het taggen van elementen in datasets over. Met experts bedoelen we KMO's en domeinautoriteiten die precies weten wat ze moeten annoteren. Het handmatige proces begint wanneer annotators worden voorzien van onbewerkte datasets voor annotatie. De datasets kunnen afbeeldingen, videobestanden, geluidsopnamen of transcripties, teksten of een combinatie hiervan zijn.

Op basis van projecten, vereiste resultaten en specificaties werken annotators aan het annoteren van relevante elementen. Experts weten welke techniek het meest geschikt is voor specifieke datasets en doeleinden. Ze gebruiken de juiste techniek voor hun projecten en leveren op tijd trainbare datasets.

Hoewel handmatig labelen slechts een onderdeel van het proces is, is er een tweede fase in de annotatieworkflow die kwaliteitscontroles en audits wordt genoemd. Hierin worden geannoteerde datasets geverifieerd op authenticiteit en precisie. Om dit te doen, passen bedrijven een consensusmethode toe, waarbij meerdere annotaties op dezelfde datasets werken voor unanieme resultaten. Verschillen worden ook opgelost in het geval van opmerkingen en markeringen. In vergelijking met het annotatieproces is de kwaliteitscontrolefase minder inspannend en tijdrovend.

Automatische gegevenslabels

U begrijpt nu dus hoeveel handmatige inspanning er gaat zitten in het labelen van gegevens. Voor oplossingen die worden gebruikt in sectoren als gezondheidszorg, wordt precisie en aandacht voor detail des te belangrijker. Om de weg vrij te maken voor snellere gegevenslabeling en levering van geannoteerde gegevens, worden modellen voor automatische gegevenslabeling geleidelijk prominenter.

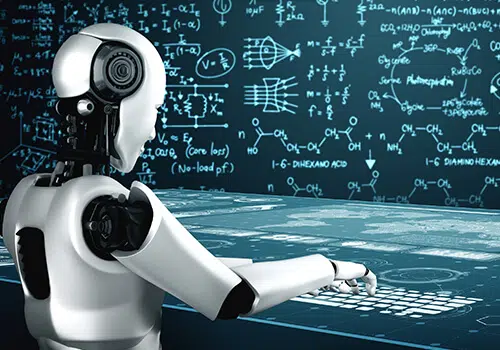

Bij deze methode zorgen AI-systemen voor het annoteren van gegevens. Dit wordt bereikt met behulp van heuristische methoden of machinale leermodellen of beide. Bij de heuristische methode wordt een enkele dataset door een reeks vooraf gedefinieerde regels of voorwaarden geleid om een specifiek label te valideren. De voorwaarden worden door mensen gelegd.

Hoewel dit efficiënt is, mislukt deze methode wanneer gegevensstructuren vaak veranderen. Ook wordt het opstellen van voorwaarden complex om systemen aan te drijven om een weloverwogen beslissing te nemen. Hoewel mensen onderscheid kunnen maken tussen ijs en limonade, weten we niet welke benadering de hersenen volgen om tot het onderscheid te komen. Om dit te repliceren is menselijk onmogelijk in machines.

Dit geeft aanleiding tot een aantal zorgen met betrekking tot de kwaliteit van de resultaten van AI-systemen. Ondanks dat de automatisering begint, heb je een mens (of een aantal van hen) nodig om gegevenslabels te valideren en op te lossen. En dit is een uitstekend vervolg op onze volgende sectie.

AI-ondersteunde annotatie: intelligentie vereist hersenen (hybride benadering)

Voor de beste resultaten is een hybride aanpak vereist. Hoewel AI-systemen voor snellere etikettering kunnen zorgen, kunnen mensen resultaten valideren en optimaliseren. Het kan een slecht idee zijn om het hele proces van gegevensannotatie aan machines over te laten en daarom is het volkomen logisch om mensen in de lus te betrekken.

Er is een evenwicht gevonden en het proces kan ook op kosteneffectieve manieren plaatsvinden. Experts zouden geoptimaliseerde feedbackloops voor machines kunnen bedenken om betere labels te produceren, waardoor uiteindelijk de noodzaak voor handmatige inspanningen wordt verminderd. Met de aanzienlijke toename van de machinevertrouwensscores kan ook de kwaliteit van gelabelde gegevens worden verbeterd.

Afsluiten

Volledig autonoom data-etikettering mechanismen zouden nooit werken - althans voorlopig. Wat we nodig hebben is harmonie tussen mens en machine bij het volbrengen van een vervelende taak. Dit verhoogt ook de levertijd van geannoteerde datasets, waar bedrijven naadloos hun AI-trainingsfasen kunnen initiëren. En als u op zoek bent naar hoogwaardige datasets voor uw AI-modellen, neem vandaag nog contact met ons op.