Wat zijn trainingsgegevens in machine learning:

Definitie, Voordelen, Uitdagingen, Voorbeeld & Datasets

De ultieme kopersgids 2023

Introductie

In de wereld van kunstmatige intelligentie en machine learning is datatraining onvermijdelijk. Dit is het proces dat machine learning-modules nauwkeurig, efficiënt en volledig functioneel maakt. In dit bericht onderzoeken we in detail wat AI-trainingsgegevens zijn, de kwaliteit van trainingsgegevens, gegevensverzameling en -licenties en meer.

Geschat wordt dat volwassenen gemiddeld genomen beslissingen nemen over het leven en alledaagse dingen op basis van geleerdheid uit het verleden. Deze komen op hun beurt voort uit levenservaringen die zijn gevormd door situaties en mensen. In de letterlijke zin zijn situaties, instanties en mensen niets anders dan gegevens die in onze geest worden ingevoerd. Omdat we jaren aan gegevens verzamelen in de vorm van ervaring, heeft de menselijke geest de neiging om naadloze beslissingen te nemen.

Wat brengt dit over? Die gegevens zijn onvermijdelijk bij het leren.

Net zoals een kind een label, een alfabet, nodig heeft om de letters A, B, C en D te begrijpen, moet een machine ook de gegevens die het ontvangt, begrijpen.

Dat is precies wat Artificial Intelligence (AI) opleiding draait om. Een machine is niet anders dan een kind dat nog dingen moet leren van wat ze gaan leren. De machine kan geen onderscheid maken tussen een kat en een hond of een bus en een auto, omdat ze die items nog niet hebben ervaren of geleerd hebben hoe ze eruitzien.

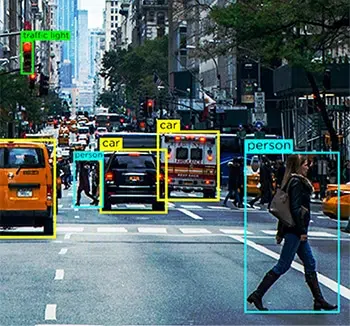

Dus voor iemand die een zelfrijdende auto bouwt, is de belangrijkste functie die moet worden toegevoegd, het vermogen van het systeem om alle alledaagse elementen die de auto kan tegenkomen te begrijpen, zodat het voertuig ze kan identificeren en passende rijbeslissingen kan nemen. Dit is waar AI-trainingsgegevens in het spel komt.

Tegenwoordig bieden kunstmatige-intelligentiemodules ons veel gemakken in de vorm van aanbevelingsmotoren, navigatie, automatisering en meer. Dat komt allemaal door AI-datatraining die werd gebruikt om de algoritmen te trainen terwijl ze werden gebouwd.

AI-trainingsgegevens zijn een fundamenteel proces bij het bouwen machine learning en AI-algoritmen. Als u een app ontwikkelt die is gebaseerd op deze technische concepten, moet u uw systemen trainen om gegevenselementen te begrijpen voor een optimale verwerking. Zonder training is uw AI-model inefficiënt, gebrekkig en mogelijk zinloos.

Geschat wordt dat datawetenschappers meer dan 80% van hun tijd in Data Preparation & Enrichment om ML-modellen te trainen.

Dus voor degenen onder u die financiering willen krijgen van durfkapitalisten, de solopreneurs die aan ambitieuze projecten werken en tech-enthousiastelingen die net zijn begonnen met geavanceerde AI, hebben we deze gids ontwikkeld om de belangrijkste vragen over uw AI-trainingsgegevens.

Hier zullen we onderzoeken wat AI-trainingsgegevens zijn, waarom het onvermijdelijk is in uw proces, de hoeveelheid en kwaliteit van gegevens die u daadwerkelijk nodig heeft, en meer.

Wat zijn AI-trainingsgegevens?

AI-trainingsgegevens zijn zorgvuldig samengestelde en opgeschoonde informatie die voor trainingsdoeleinden in een systeem wordt ingevoerd. Dit proces maakt of breekt het succes van een AI-model. Het kan helpen bij het ontwikkelen van het begrip dat niet alle viervoetige dieren in een afbeelding honden zijn, of het kan een model helpen onderscheid te maken tussen boos geschreeuw en vrolijk gelach. Het is de eerste fase in het bouwen van kunstmatige-intelligentiemodules waarvoor gegevens met een lepel nodig zijn om machines de basis te leren en hen in staat te stellen te leren naarmate er meer gegevens worden ingevoerd. Dit maakt opnieuw plaats voor een efficiënte module die nauwkeurige resultaten oplevert voor eindgebruikers.

Beschouw een AI-trainingsgegevensproces als een oefensessie voor een muzikant, waarbij hoe meer ze oefenen, hoe beter ze worden in een nummer of een toonladder. Het enige verschil hier is dat machines ook eerst moeten leren wat een muziekinstrument is. Net als de muzikant die de ontelbare uren besteedt aan oefenen op het podium, biedt een AI-model een optimale beleving aan de consument wanneer deze wordt ingezet.

Waarom zijn AI-trainingsgegevens vereist?

Het eenvoudigste antwoord op de vraag waarom AI-trainingsgegevens nodig zijn voor de ontwikkeling van een model, is dat machines zonder dit niet eens zouden weten wat ze moeten begrijpen. Net als een persoon die is opgeleid voor zijn specifieke taak, heeft een machine een verzameling informatie nodig om een specifiek doel te dienen en ook overeenkomstige resultaten te leveren.

Laten we nog eens kijken naar het voorbeeld van autonome auto's. Terabytes na terabytes aan gegevens in een zelfrijdend voertuig komen van meerdere sensoren, computer vision-apparaten, RADAR, LIDAR's en nog veel meer. Al deze enorme brokken data zouden zinloos zijn als het centrale verwerkingssysteem van de auto niet weet wat het ermee aan moet.

Bijvoorbeeld, de computer visie De eenheid van de auto zou grote hoeveelheden gegevens kunnen uitspuwen over wegelementen zoals voetgangers, dieren, kuilen en meer. Als de machine learning-module niet is getraind om ze te identificeren, zou het voertuig niet weten dat het hindernissen zijn die ongevallen kunnen veroorzaken als ze worden aangetroffen. Daarom moeten de modules worden getraind in wat elk afzonderlijk element in de weg is en hoe verschillende rijbeslissingen voor elk ervan nodig zijn.

Hoewel dit alleen voor visuele elementen is, moet de auto ook menselijke instructies kunnen begrijpen Natuurlijke taalverwerking (NLP) en audio- of spraakverzameling en dienovereenkomstig reageren. Als de bestuurder bijvoorbeeld het infotainmentsysteem in de auto opdracht geeft om naar benzinestations in de buurt te zoeken, moet hij de vereiste kunnen begrijpen en passende resultaten kunnen opleveren. Daarvoor moet het echter elk woord in de zin kunnen begrijpen, verbinden en de vraag kunnen begrijpen.

Hoewel je je kunt afvragen of het proces van AI-trainingsgegevens alleen complex is omdat het wordt ingezet voor een intensief gebruik, zoals een autonome auto, is het een feit dat zelfs de volgende film die Netflix aanbeveelt hetzelfde proces doorloopt om je gepersonaliseerde suggesties te bieden. Elke app, elk platform of een entiteit waaraan AI is gekoppeld, wordt standaard aangedreven door AI-trainingsgegevens.

Welke soorten gegevens heb ik nodig?

Er zijn 4 primaire soorten gegevens die nodig zijn, namelijk afbeelding, video, audio/spraak of tekst om machine learning-modellen effectief te trainen. Het type gegevens dat nodig is, is afhankelijk van verschillende factoren, zoals het gebruiksscenario, de complexiteit van de te trainen modellen, de gebruikte trainingsmethode en de diversiteit aan vereiste invoergegevens.

Hoeveel gegevens zijn voldoende?

Ze zeggen dat er geen einde komt aan leren en deze zin is ideaal in het dataspectrum van AI-trainingen. Hoe meer gegevens, hoe beter de resultaten. Een zo vaag antwoord is echter niet genoeg om iemand te overtuigen die een AI-aangedreven app wil lanceren. Maar de realiteit is dat er geen algemene vuistregel, formule, index of meting is van het exacte datavolume dat men nodig heeft om hun AI-datasets te trainen.

Een expert op het gebied van machine learning zou komisch onthullen dat er een apart algoritme of module moet worden gebouwd om de hoeveelheid gegevens af te leiden die nodig zijn voor een project. Dat is helaas ook de realiteit.

Nu is er een reden waarom het extreem moeilijk is om een limiet te stellen aan de hoeveelheid gegevens die nodig is voor AI-training. Dit komt door de complexiteit van het trainingsproces zelf. Een AI-module bestaat uit meerdere lagen van onderling verbonden en overlappende fragmenten die elkaars processen beïnvloeden en aanvullen.

Laten we bijvoorbeeld aannemen dat u een eenvoudige app aan het ontwikkelen bent om een kokospalm te herkennen. Vanuit het perspectief klinkt het vrij eenvoudig, toch? Vanuit AI-perspectief is het echter veel complexer.

Helemaal aan het begin is de machine leeg. Het weet in de eerste plaats niet wat een boom is, laat staan een hoge, regiospecifieke, tropische vruchtdragende boom. Daarvoor moet het model worden getraind in wat een boom is, hoe het kan worden onderscheiden van andere lange en slanke objecten die in beeld kunnen verschijnen, zoals straatlantaarns of elektrische palen, en vervolgens verder gaan om het de nuances van een kokospalm te leren. Als de machine learning-module eenmaal heeft geleerd wat een kokospalm is, kun je er gerust vanuit gaan dat hij weet hoe hij er een kan herkennen.

Maar alleen als je een afbeelding van een banyanboom invoert, zou je beseffen dat het systeem een banyanboom verkeerd heeft geïdentificeerd voor een kokospalm. Voor een systeem is alles wat hoog is met geclusterd blad een kokospalm. Om dit te elimineren, moet het systeem nu elke afzonderlijke boom begrijpen die geen kokospalm is om precies te kunnen identificeren. Als dit het proces is voor een eenvoudige unidirectionele app met slechts één uitkomst, kunnen we ons alleen de complexiteit voorstellen van apps die zijn ontwikkeld voor de gezondheidszorg, financiën en meer.

Wat is daarnaast ook van invloed op de hoeveelheid data die nodig is voor: training omvat onderstaande aspecten:

- Trainingsmethode, waarbij de verschillen in datatypes (gestructureerde en ongestructureerd) de behoefte aan datavolumes beïnvloeden

- Gegevensetikettering of annotatietechnieken

- De manier waarop gegevens naar een systeem worden gevoerd

- Fouttolerantiequotiënt, wat eenvoudigweg het percentage van betekent fouten die verwaarloosbaar zijn in uw niche of domein

Voorbeelden uit de praktijk van trainingsvolumes

Hoewel de hoeveelheid data die je nodig hebt om je modules te trainen afhankelijk is op uw project en de andere factoren die we eerder hebben besproken, een beetje inspiratie of referentie zou helpen om een uitgebreid idee van data te krijgen vereisten.

Hieronder volgen voorbeelden uit de praktijk van het aantal gebruikte datasets voor AI-trainingsdoeleinden door diverse bedrijven en bedrijven.

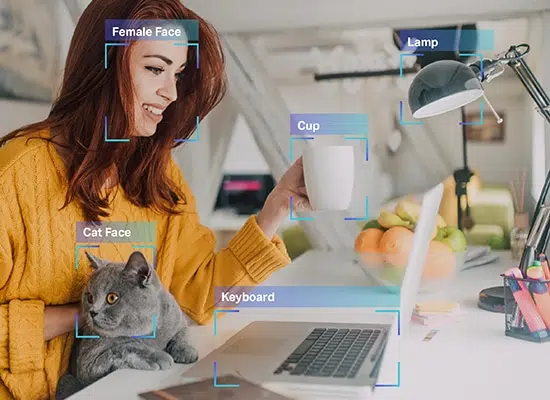

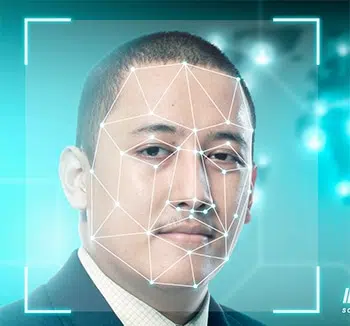

- Gezichtsherkenning – een steekproefomvang van meer dan 450,000 gezichtsopnamen

- Annotatie afbeelding – een steekproefomvang van meer dan 185,000 afbeeldingen met bijna 650,000 geannoteerde objecten

- Facebook-sentimentanalyse – een steekproefomvang van meer dan 9,000 opmerkingen en 62,000 berichten

- Chatbot-training – een steekproefomvang van meer dan 200,000 vragen met meer dan 2 miljoen antwoorden

- Vertaal-app – een steekproefomvang van meer dan 300,000 audio of spraak verzameling van niet-moedertaalsprekers

Wat als ik niet genoeg gegevens heb?

In de wereld van AI & ML is datatraining onvermijdelijk. Er wordt terecht gezegd dat er geen einde komt aan het leren van nieuwe dingen en dit geldt ook als we het hebben over het AI-trainingsdataspectrum. Hoe meer gegevens, hoe beter de resultaten. Er zijn echter gevallen waarin de use case die u probeert op te lossen betrekking heeft op een nichecategorie, en het vinden van de juiste dataset op zich is een uitdaging. Dus in dit scenario, als u niet over voldoende gegevens beschikt, zijn de voorspellingen van het ML-model mogelijk niet nauwkeurig of kunnen ze vertekend zijn. Er zijn manieren zoals gegevensvergroting en gegevensopmaak die u kunnen helpen de tekortkomingen te verhelpen, maar het resultaat is mogelijk nog steeds niet nauwkeurig of betrouwbaar.

Hoe verbeter je de datakwaliteit?

De kwaliteit van gegevens is recht evenredig met de kwaliteit van de output. Daarom vereisen zeer nauwkeurige modellen datasets van hoge kwaliteit voor training. Er is echter een vangst. Voor een concept dat afhankelijk is van precisie en nauwkeurigheid, is het concept kwaliteit vaak nogal vaag.

Gegevens van hoge kwaliteit klinken sterk en geloofwaardig, maar wat betekent het eigenlijk?

Wat is kwaliteit in de eerste plaats?

Welnu, net als de gegevens die we in onze systemen invoeren, heeft kwaliteit ook veel factoren en parameters die ermee samenhangen. Als u contact opneemt met AI-experts of machine learning-veteranen, kunnen ze elke permutatie van hoogwaardige gegevens delen, is alles wat -

- Uniform – data die uit één bepaalde bron komen of uniformiteit in datasets die uit meerdere bronnen komen

- Voor informatie over passend onderwijs, zie: www.passendonderwijs.nl – gegevens die alle mogelijke scenario's dekken waar uw systeem aan moet werken

- Consistent - elke byte aan gegevens is vergelijkbaar van aard

- Relevant – de gegevens die u sourcet en invoert, zijn vergelijkbaar met uw vereisten en verwachte resultaten en

- Diversiteit – je hebt een combinatie van alle soorten gegevens zoals audio, video, afbeelding, tekst en meer

Nu we begrijpen wat kwaliteit in gegevenskwaliteit betekent, gaan we snel kijken naar de verschillende manieren waarop we kwaliteit kunnen waarborgen het verzamelen van gegevens en generatie.

1. Let op gestructureerde en ongestructureerde data. De eerste is gemakkelijk te begrijpen door machines omdat ze geannoteerde elementen en metadata hebben. Dit laatste is echter nog steeds onbewerkt en bevat geen waardevolle informatie waar een systeem gebruik van kan maken. Dit is waar gegevensannotatie binnenkomt.

2. Het elimineren van vooroordelen is een andere manier om kwaliteitsgegevens te garanderen, aangezien het systeem alle vooroordelen uit het systeem verwijdert en een objectief resultaat oplevert. Bias vertekent alleen uw resultaten en maakt het zinloos.

3. Ruim gegevens uitgebreid op, omdat dit altijd de kwaliteit van uw output zal verhogen. Elke datawetenschapper zou u vertellen dat een belangrijk deel van hun taak bestaat uit het opschonen van gegevens. Wanneer u uw gegevens opschoont, verwijdert u duplicaat, ruis, ontbrekende waarden, structurele fouten enz.

Wat beïnvloedt de kwaliteit van trainingsgegevens?

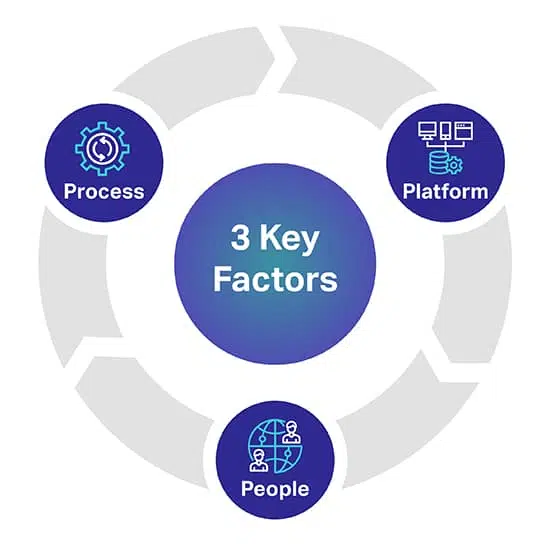

Er zijn drie belangrijke factoren die u kunnen helpen bij het voorspellen van het gewenste kwaliteitsniveau voor uw AI/ML-modellen. De 3 belangrijkste factoren zijn mensen, processen en platformen die uw AI-project kunnen maken of breken.

Platform: Er is een volledig eigen platform nodig om diverse datasets te sourcen, transcriberen en annoteren om de meest veeleisende AI- en ML-initiatieven met succes te implementeren. Het platform is ook verantwoordelijk voor het beheren van werknemers en het maximaliseren van kwaliteit en doorvoer

People: Om AI slimmer te laten denken, zijn mensen nodig die tot de slimste koppen in de branche behoren. Om te schalen heb je duizenden van deze professionals over de hele wereld nodig om alle datatypes te transcriberen, te labelen en te annoteren.

Werkwijze: Het leveren van gouden standaardgegevens die consistent, volledig en nauwkeurig zijn, is complex werk. Maar het is wat u altijd zult moeten leveren, om te voldoen aan de hoogste kwaliteitsnormen en aan strenge en bewezen kwaliteitscontroles en controlepunten.

Waar haal je AI-trainingsgegevens vandaan?

In tegenstelling tot onze vorige sectie hebben we hier een heel precies inzicht. Voor degenen onder u die op zoek zijn naar brongegevens

of als je bezig bent met het verzamelen van video's, het verzamelen van afbeeldingen, het verzamelen van tekst en meer, zijn er drie

primaire wegen waar u uw gegevens vandaan kunt halen.

Laten we ze afzonderlijk onderzoeken.

Gratis bronnen

Gratis bronnen zijn wegen die onvrijwillige opslagplaatsen zijn van enorme hoeveelheden gegevens. Het zijn gegevens die gewoon gratis op de oppervlakte liggen. Enkele van de gratis bronnen zijn:

- Google-datasets, waar in 250 meer dan 2020 miljoen datasets zijn vrijgegeven

- Forums zoals Reddit, Quora en meer, die vindingrijke bronnen voor gegevens zijn. Bovendien kunnen datawetenschaps- en AI-gemeenschappen in deze forums u ook helpen met bepaalde datasets wanneer u contact opneemt.

- Kaggle is een andere gratis bron waar u naast gratis datasets ook bronnen voor machine learning kunt vinden.

- We hebben ook gratis open datasets vermeld om u op weg te helpen met het trainen van uw AI-modellen

Hoewel deze mogelijkheden gratis zijn, zou u uiteindelijk tijd en moeite besteden. Gegevens uit gratis bronnen zijn overal aanwezig en u moet urenlang werken aan het zoeken, opschonen en aanpassen aan uw behoeften.

Een van de andere belangrijke punten om te onthouden is dat sommige gegevens uit gratis bronnen ook niet voor commerciële doeleinden kunnen worden gebruikt. Het heeft nodig gegevenslicenties.

Gegevensschrapen

Zoals de naam al doet vermoeden, is datascraping het proces van het ontginnen van gegevens uit meerdere bronnen met behulp van geschikte tools. Van websites, openbare portals, profielen, tijdschriften, documenten en meer, tools kunnen de gegevens die u nodig hebt schrapen en deze naadloos naar uw database brengen.

Hoewel dit klinkt als een ideale oplossing, is datascraping alleen legaal als het gaat om persoonlijk gebruik. Als u een bedrijf bent dat gegevens wil schrapen met commerciële ambities, wordt het lastig en zelfs illegaal. Daarom heb je een juridisch team nodig om naar websites, naleving en voorwaarden te kijken voordat je gegevens kunt schrapen die je nodig hebt.

Externe leveranciers

Wat betreft het verzamelen van gegevens voor AI-trainingsgegevens, is outsourcing of het benaderen van externe leveranciers voor datasets de meest ideale optie. Zij nemen de verantwoordelijkheid voor het vinden van datasets voor uw vereisten, terwijl u zich kunt concentreren op het bouwen van uw modules. Dit is specifiek vanwege de volgende redenen -

- je hoeft geen uren te zoeken naar databronnen

- er zijn geen inspanningen op het gebied van gegevensopschoning en classificatie betrokken

- u krijgt hoogwaardige datasets bij de hand die nauwkeurig alle factoren afvinken die we enige tijd geleden hebben besproken

- u kunt datasets krijgen die zijn afgestemd op uw behoeften

- je zou de hoeveelheid gegevens kunnen eisen die je nodig hebt voor je project en meer

- en het belangrijkste is dat ze er ook voor zorgen dat hun gegevensverzameling en de gegevens zelf voldoen aan de lokale wettelijke richtlijnen.

De enige factor die een tekortkoming kan blijken te zijn, afhankelijk van uw omvang van de activiteiten, is dat outsourcing kosten met zich meebrengt. Nogmaals, wat geen kosten met zich meebrengt.

Shaip is al een leider op het gebied van gegevensverzamelingsservices en heeft een eigen opslagplaats van gezondheidsgegevens en spraak-/audiodatasets die kunnen worden gelicentieerd voor uw ambitieuze AI-projecten.

Open Datasets – Wel of niet gebruiken?

Er is bijvoorbeeld de dataset met productrecensies van Amazon met meer dan 142 miljoen gebruikersrecensies van 1996 tot 2014. Voor afbeeldingen heb je een uitstekende bron zoals Google Open Images, waar je datasets van meer dan 9 miljoen afbeeldingen kunt vinden. Google heeft ook een vleugel genaamd Machine Perception die bijna 2 miljoen audioclips biedt met een duur van tien seconden.

Ondanks de beschikbaarheid van deze bronnen (en andere), is de belangrijke factor die vaak over het hoofd wordt gezien de voorwaarden die gepaard gaan met het gebruik ervan. Ze zijn zeker openbaar, maar er is een dunne lijn tussen inbreuk en redelijk gebruik. Elke bron heeft zijn eigen voorwaarde en als u deze opties verkent, raden we u aan voorzichtig te zijn. Dit komt omdat u, onder het voorwendsel dat u de voorkeur geeft aan gratis wegen, rechtszaken en aanverwante kosten kunt oplopen.

De echte kosten van AI-trainingsgegevens

Alleen het geld dat u uitgeeft om de gegevens in te kopen of in-house gegevens te genereren, is niet wat u moet overwegen. We moeten rekening houden met lineaire elementen zoals tijd en inspanningen die zijn besteed aan het ontwikkelen van AI-systemen en kosten vanuit een transactieperspectief. slaagt er niet in de ander te complimenteren.

Tijd besteed aan het sourcen en annoteren van gegevens

Factoren zoals geografie, marktdemografie en concurrentie binnen uw niche belemmeren de beschikbaarheid van relevante datasets. De tijd die u besteedt aan het handmatig zoeken naar gegevens is tijdverspilling bij het trainen van uw AI-systeem. Zodra u erin slaagt uw gegevens te sourcen, stelt u de training verder uit door tijd te besteden aan het annoteren van de gegevens, zodat uw machine kan begrijpen wat er wordt ingevoerd.

De prijs van het verzamelen en annoteren van gegevens

Overheadkosten (interne gegevensverzamelaars, annotators, onderhoud van apparatuur, technische infrastructuur, abonnementen op SaaS-tools, ontwikkeling van propriëtaire applicaties) moeten worden berekend tijdens het sourcen van AI-gegevens

De kosten van slechte gegevens

Slechte gegevens kunnen het moreel van uw bedrijfsteam, uw concurrentievoordeel en andere tastbare gevolgen kosten die onopgemerkt blijven. We definiëren slechte gegevens als elke dataset die onrein, onbewerkt, irrelevant, verouderd, onnauwkeurig of vol spelfouten is. Slechte gegevens kunnen uw AI-model bederven door vooringenomenheid te introduceren en uw algoritmen te corrumperen met scheve resultaten.

Beheerskosten

Alle kosten met betrekking tot de administratie van uw organisatie of onderneming, materiële en immateriële zaken zijn beheerskosten die vaak het duurst zijn.

Wat nu na Data Sourcing?

Zodra u de dataset in uw hand heeft, is de volgende stap om deze te annoteren of te labelen. Na alle complexe taken heb je schone onbewerkte gegevens. De machine kan de gegevens die u heeft nog steeds niet begrijpen, omdat deze niet zijn geannoteerd. Dit is waar het resterende deel van de echte uitdaging begint.

Zoals we al zeiden, heeft een machine gegevens nodig in een formaat dat het kan begrijpen. Dit is precies wat gegevensannotatie doet. Het neemt onbewerkte gegevens en voegt lagen labels en tags toe om een module te helpen elk afzonderlijk element in de gegevens nauwkeurig te begrijpen.

In een tekst vertelt datalabeling een AI-systeem bijvoorbeeld de grammaticale syntaxis, woordsoorten, voorzetsels, interpunctie, emotie, sentiment en andere parameters die betrokken zijn bij het begrijpen van machines. Dit is hoe chatbots menselijke gesprekken beter begrijpen en alleen als ze dat doen, kunnen ze ook menselijke interacties beter nabootsen door middel van hun reacties.

Hoe onvermijdelijk het ook klinkt, het is ook extreem tijdrovend en vervelend. Ongeacht de schaal van uw bedrijf of de ambities, de tijd die nodig is om gegevens te annoteren is enorm.

Dit komt in de eerste plaats omdat uw bestaande personeel tijd moet besteden aan het annoteren van gegevens als u geen gegevensannotatiespecialisten hebt. Je moet dus je teamleden oproepen en dit als een extra taak toewijzen. Hoe meer vertraging, hoe langer het duurt om je AI-modellen te trainen.

Hoewel er gratis tools zijn voor het annoteren van gegevens, neemt dat niet weg dat dit proces tijdrovend is.

Dat is waar leveranciers van gegevensannotatie zoals Shaip binnenkomen. Ze brengen een toegewijd team van specialisten op het gebied van gegevensannotatie met zich mee om zich alleen op uw project te concentreren. Zij bieden u oplossingen op de manier die u wenst voor uw wensen en eisen. Bovendien kunt u met hen een tijdschema instellen en eisen dat het werk in die specifieke tijdlijn wordt voltooid.

Een van de belangrijkste voordelen is dat uw interne teamleden zich kunnen blijven concentreren op wat belangrijker is voor uw activiteiten en project, terwijl experts hun werk doen om gegevens voor u te annoteren en te labelen.

Met outsourcing kunnen optimale kwaliteit, minimale tijd en maximale precisie worden gegarandeerd.

Afsluiten

Dat was alles over AI-trainingsgegevens. Van inzicht in wat trainingsgegevens zijn tot het verkennen van gratis bronnen en voordelen van outsourcing van gegevensannotatie, we hebben ze allemaal besproken. Nogmaals, protocollen en beleid zijn nog steeds wankel in dit spectrum en we raden je altijd aan om contact op te nemen met AI-trainingsdata-experts zoals wij voor jouw behoeften.

Van sourcing, de-identificatie tot annotatie van gegevens, wij helpen u met al uw behoeften, zodat u alleen kunt werken aan het bouwen van uw platform. We begrijpen de fijne kneepjes van het verzamelen en labelen van gegevens. Daarom herhalen we nogmaals dat u de moeilijke taken aan ons kunt overlaten en gebruik kunt maken van onze oplossingen.

Neem vandaag nog contact met ons op voor al uw behoeften op het gebied van gegevensaantekeningen.

Laten we praten

Veel gestelde vragen (FAQ)

Als u intelligente systemen wilt maken, moet u opgeschoonde, samengestelde en bruikbare informatie invoeren om begeleid leren mogelijk te maken. De gelabelde informatie wordt AI-trainingsgegevens genoemd en omvat marktmetadata, ML-algoritmen en alles wat helpt bij het nemen van beslissingen.

Elke AI-aangedreven machine heeft mogelijkheden die worden beperkt door zijn historische plaats. Dit betekent dat de machine alleen de gewenste uitkomst kan voorspellen als deze eerder is getraind met vergelijkbare datasets. Trainingsgegevens helpen bij training onder toezicht, waarbij het volume recht evenredig is met de efficiëntie en nauwkeurigheid van de AI-modellen.

Er zijn verschillende trainingsdatasets nodig om specifieke Machine Learning-algoritmen te trainen, om de AI-gestuurde setups te helpen belangrijke beslissingen te nemen met de context in gedachten. Als u bijvoorbeeld Computer Vision-functionaliteit aan een machine wilt toevoegen, moeten de modellen worden getraind met geannoteerde afbeeldingen en meer marktgegevenssets. Evenzo fungeren voor NLP-vaardigheid grote hoeveelheden spraakverzameling als trainingsgegevens.

Er is geen bovengrens aan de hoeveelheid trainingsgegevens die nodig zijn om een competent AI-model te trainen. Hoe groter het datavolume, hoe beter het model in staat is om elementen, teksten en contexten te identificeren en te scheiden.

Hoewel er veel data beschikbaar is, is niet elke chunk geschikt voor trainingsmodellen. Om een algoritme optimaal te laten werken, hebt u uitgebreide, consistente en relevante datasets nodig, die uniform worden geëxtraheerd maar toch divers genoeg zijn om een breed scala aan scenario's te dekken. Ongeacht de gegevens die u van plan bent te gebruiken, is het beter om deze op te schonen en te annoteren voor verbeterd leren.

Als je een bepaald AI-model in gedachten hebt, maar de trainingsgegevens niet voldoende zijn, moet je eerst uitschieters verwijderen, overdrachts- en iteratieve leeropstellingen koppelen, functionaliteiten beperken en de opstelling open-source maken zodat de gebruikers gegevens kunnen blijven toevoegen voor de machine, geleidelijk, in de tijd trainen. U kunt zelfs benaderingen volgen met betrekking tot data-augmentatie en transfer learning om het meeste uit beperkte datasets te halen.

Open datasets kunnen altijd worden gebruikt voor het verzamelen van trainingsgegevens. Als u echter exclusiviteit zoekt om de modellen beter te trainen, kunt u vertrouwen op externe leveranciers, gratis bronnen zoals Reddit, Kaggle en meer, en zelfs Data Scraping voor het selectief ontginnen van inzichten uit profielen, portals en documenten. Ongeacht de aanpak is het noodzakelijk om de verkregen gegevens te formatteren, te verkleinen en op te schonen voordat ze worden gebruikt.