In het snelgroeiende veld van kunstmatige intelligentie (AI) is de focus op ethische overwegingen en eerlijkheid meer dan een morele imperatief: het is een fundamentele noodzaak voor de lange levensduur en sociale acceptatie van de technologie. Ethische AI, of Eerlijke AI, gaat over het garanderen dat AI-systemen functioneren zonder vooringenomenheid, discriminatie of onrechtvaardige uitkomsten. Deze blog onderzoekt het belang van ethische AI en gaat in op de verschillende soorten vooroordelen die je moet vermijden.

Waarom ethische AI belangrijk is

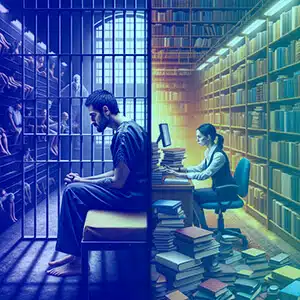

AI-systemen worden steeds meer onderdeel van ons dagelijks leven en nemen beslissingen die van invloed zijn op alles, van sollicitaties tot gerechtelijke veroordelingen. Wanneer deze systemen bevooroordeeld zijn, kunnen ze de maatschappelijke ongelijkheid in stand houden en versterken, waardoor individuen en groepen schade worden berokkend. Ethische AI heeft tot doel dergelijke uitkomsten te voorkomen door eerlijkheid, verantwoordingsplicht, transparantie en respect voor de mensenrechten te bevorderen.

Soorten vooroordelen en voorbeelden

Geweldsvooroordeel

AI-systemen moeten worden getraind om gewelddadige inhoud te herkennen en weg te laten. Een taalmodel dat is getraind op gewelddadige teksten kan bijvoorbeeld schadelijke inhoud genereren en agressie bevorderen in plaats van een constructieve dialoog.

Controversiële onderwerpen

Het trainen van AI op controversiële onderwerpen zonder zorgvuldige moderatie kan ertoe leiden dat de AI gepolariseerde standpunten inneemt. Een AI die is getraind op basis van gegevens over wapenrechten kan bijvoorbeeld controversiële en eenzijdige argumenten opleveren.

Geslachtsvooroordelen

Een klassiek voorbeeld van gendervooroordelen is wanneer een taalmodel verpleegkundigen associeert met vrouwen en ingenieurs met mannen, waardoor verouderde stereotypen worden versterkt in plaats van de diversiteit van deze beroepen te weerspiegelen.

Raciale en etnische vooroordelen

Denk eens aan een AI die afbeeldingen van CEO’s genereert, maar hen voornamelijk afbeeldt als behorend tot één enkele raciale groep, en daarmee de realiteit van diversiteit binnen de bedrijfswereld negeert.

Sociaal-economische vooringenomenheid

AI-systemen kunnen de voorkeur geven aan taal of concepten die verband houden met een hogere sociaal-economische status, zoals de veronderstelling dat luxemerken de standaard voor kwaliteit zijn, waarbij het bredere spectrum van consumentenervaringen over het hoofd wordt gezien.

Leeftijdsbias

AI zou ten onrechte kunnen aannemen dat verwijzingen naar technologie niet relevant zijn voor oudere volwassenen, waardoor ze worden uitgesloten van gesprekken over digitale ontwikkelingen.

Culturele vooringenomenheid

Een AI-systeem zou restaurantrecensies kunnen genereren die zich richten op de westerse keuken, waarbij de rijkdom van andere culinaire tradities wordt genegeerd en daarmee niet-westerse culturen worden gemarginaliseerd.

Politieke vooringenomenheid

Een AI die geprogrammeerd is om nieuwsartikelen samen te stellen, zou onevenredig veel artikelen aan de linker- of rechterkant van het politieke spectrum kunnen selecteren, in plaats van een evenwichtig beeld te presenteren.

Religieuze vooroordelen

Als een AI-systeem disproportioneel in een positief daglicht naar één religie verwijst en andere religies negeert of verkeerd voorstelt, vertoont het religieuze vooroordelen.

Regionale vooringenomenheid

Een taalmodel kan verkeersrapporten genereren die alleen relevant zijn voor stedelijke gebieden, waarbij landelijke of dunbevolkte regio's buiten beschouwing worden gelaten.

Vooroordeel over handicap

Denk aan een AI-gezondheidsadviseur die er niet in slaagt om toegankelijke bewegingsopties te bieden aan mensen met een handicap, en daardoor onvolledig en uitsluitend advies biedt.

Taalvooroordeel

Een vertaal-AI kan voor sommige talen consistent vertalingen van hoge kwaliteit leveren, maar ondermaatse vertalingen voor talen die minder vertegenwoordigd zijn in de trainingsgegevens.

Voorkeur voor bevestiging

Een AI kan het geloof van een gebruiker in een valse remedie versterken door selectief te verwijzen naar bronnen die die remedie ondersteunen en de wetenschappelijke consensus te negeren.

Contextuele vooringenomenheid

Een AI zou verzoeken om informatie over ‘gevangenissen’ kunnen interpreteren als een strafrechtelijk onderzoek, in plaats van een academisch of juridisch onderzoek, afhankelijk van de context waarin het is getraind.

Vertekening van gegevensbronnen

Als de trainingsgegevens van een AI afkomstig zijn van een forum dat voornamelijk de prestaties van een bepaalde doelgroep bespreekt, kan het de bijdragen van andere groepen verwaarlozen.

Hoe u deze vooroordelen kunt vermijden

Het vermijden van deze vooroordelen vereist een veelzijdige aanpak:

- Diverse datasets: Integreer een breed scala aan gegevensbronnen om de vertegenwoordiging over verschillende groepen in evenwicht te brengen.

- Regelmatige audits: Voer voortdurende controles uit om vooroordelen te identificeren en te corrigeren.

- Transparantie: Maak duidelijk hoe AI-systemen beslissingen nemen en op welke data ze worden getraind.

- Inclusiviteit in AI-teams: Diverse teams kunnen potentiële vooroordelen die mogelijk over het hoofd worden gezien, beter identificeren.

- Ethiektraining: Informeer AI-ontwikkelaars over het belang van ethische overwegingen.

- Feedback van belanghebbenden: Betrek gebruikers en getroffen gemeenschappen bij het AI-ontwikkelingsproces.

Waarom Shaip

Shaip biedt als leider op het gebied van AI-dataoplossingen uitgebreide diensten die zijn ontworpen om AI-vooroordelen frontaal aan te pakken. Door diverse en uitgebalanceerde datasets aan te bieden voor het trainen van AI-modellen, zorgt Shaip ervoor dat uw AI-systemen worden blootgesteld aan een breed spectrum aan menselijke ervaringen en demografische gegevens, waardoor het risico op vooroordelen op alle fronten wordt verminderd – van geslacht en ras tot taal en handicap. Hun rigoureuze datacuratie- en annotatieprocessen, gekoppeld aan een ethisch AI-framework, kunnen organisaties helpen bij het identificeren, beperken en voorkomen van vooroordelen in AI-systemen. De expertise van Shaip in het ontwikkelen van op maat gemaakte modellen betekent ook dat ze kunnen helpen bij het creëren van AI die zo inclusief, eerlijk en onbevooroordeeld mogelijk is, in lijn met de mondiale normen van ethische AI.

Conclusie

Ethische AI is cruciaal voor het creëren van een toekomst waarin technologie de mensheid zonder vooroordelen dient. Door vooroordelen te begrijpen en te verminderen, kunnen ontwikkelaars en belanghebbenden ervoor zorgen dat AI-systemen eerlijk en rechtvaardig zijn. De verantwoordelijkheid ligt bij iedereen die betrokken is bij de levenscyclus van AI om een omgeving te bevorderen waarin technologie onze hoogste ethische normen weerspiegelt, en zo een rechtvaardige en inclusieve samenleving te bevorderen. Door waakzaamheid en toewijding aan deze principes kan AI zijn ware potentieel als kracht ten goede verwezenlijken.